by Sally Bo Hatter

Share

by Sally Bo Hatter

LLaMA (Large Language Model by Meta AI) ist ein großes Sprachmodell, das von Meta Platforms, Inc. (ehemals Facebook, Inc.) entwickelt wurde. Es wurde entwickelt, um verschiedene Aufgaben im Bereich der natürlichen Sprachverarbeitung (Natural Language Processing = NLP) zu bewältigen, darunter Texterstellung, -verständnis, -zusammenfassung, -übersetzung, Beantwortung von Fragen und andere sprachbasierte Aufgaben.

LLaMA verwendet eine Transformer-basierte Architektur, ähnlich wie andere bekannte Sprachmodelle. Die Transformer-Architektur versteht durch ihren Aufmerksamkeitsmechanismus die Beziehungen zwischen Wörtern innerhalb eines Satzes besser und kann so den Kontext besser erfassen, um einen natürlicheren Text zu generieren oder Antworten auf bestimmte Fragen zu geben.

Im Jahr 2023 veröffentlichte Meta das LLaMA2-Modell, das mit 40% mehr Daten als seine Vorgänger trainiert wurde und machte es mit einer einfachen Registrierung über die Huggingface-Plattform für jedermann zugänglich.

In diesem Artikel stellen wir Ihnen eine einfache Möglichkeit vor, einen KI-Chat mit dem LLaMA2-Modell über die Text Generation Web UI zu starten. Dieser Leitfaden basiert auf

der Windows-Umgebung und nutzt Anaconda. Anaconda kann über den folgenden Link installiert werden:

1. Erstellen einer virtuellen Conda-Umgebung

Nach der Installation von Anaconda starten Sie Anaconda Prompt über das Windows-Startmenü. Verwenden Sie dann die folgenden Befehle, um eine neue virtuelle Umgebung für diese Übung zu erstellen und sie zu aktivieren:

1 conda create -n textgen python=3.11

2 conda activate textgenDie Text Generation Web UI ist eine Anwendung, mit der Benutzer die Textgenerierungsmodelle einfach über eine Weboberfläche verwenden können. Das Projekt zielt darauf ab, fortgeschrittene KI-Funktionen wie die Verarbeitung natürlicher Sprache auch für nicht erfahrene Benutzer leicht zugänglich zu machen. Die Text Generation Web UI ist auf GitHub verfügbar:

2. Installation der Text Generation Web UI

1 git clone <https://github.com/oobabooga/text-generation-webui>

2 cd text-generation-webui

3 pip install -r requirements.txt1 conda create -n textgen python=3.11

3. Einen Token von Huggingace erhalten

Wenn Sie neu bei Huggingface sind, müssen Sie sich zunächst anmelden:

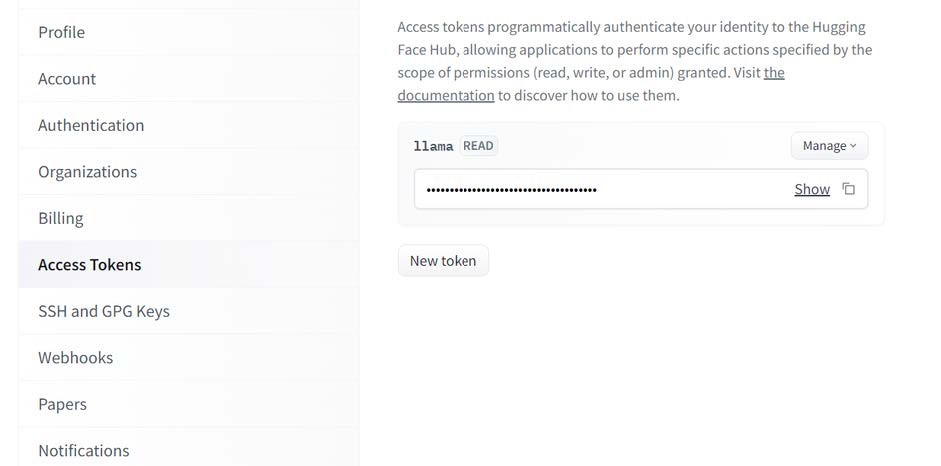

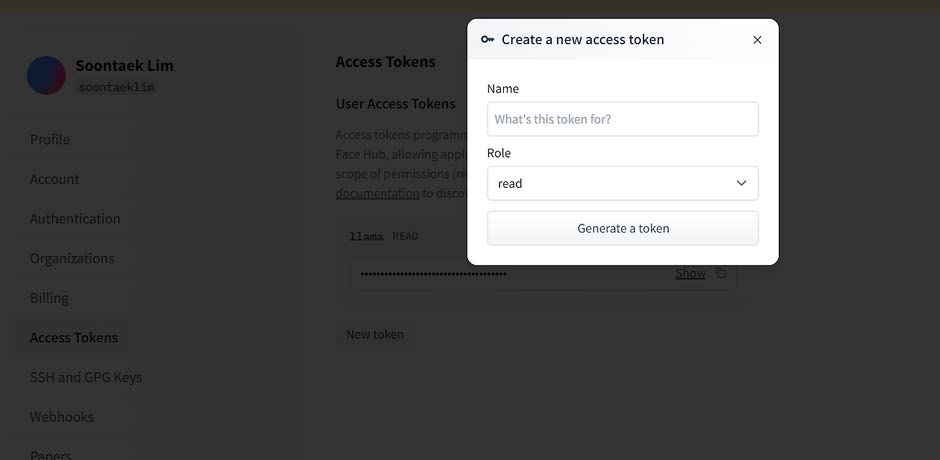

Nach der Anmeldung finden Sie in Ihrem Profil unter dem Menü „Einstellungen“ eine Registerkarte zur Verwaltung der Zugriffstoken. Erstellen Sie ein Token mit der Rolle „Read“. Dieses Token wird für die Anmeldung über die Huggingface-CLI verwendet.

4. Installation des Huggingface CLI

Wenn Sie Huggingface zum ersten Mal verwenden, installieren Sie die CLI in der Anaconda Eingabeaufforderung:

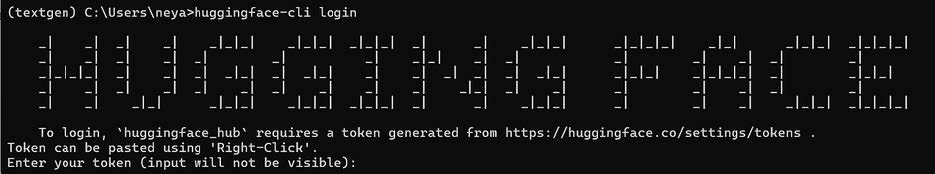

1 pip install -U "huggingface_hub[cli]"5. In Huggingface einloggen

Verwenden Sie den im vorherigen Schritt generierten Token, um sich bei Huggingface anzumelden:

1 huggingface-cli login

6. Herunterladen des LLaMA-Modells

LLaMA hat verschiedene Modelle auf der Grundlage der Größe ihrer Parameter veröffentlicht. In diesem Artikel werden wir ein Modell mit 7 Milliarden Parametern verwenden.

Zunächst müssen Sie den Zugang zu LLaMA auf Huggingface beantragen, was in der Regel innerhalb von 2 Stunden geschieht:

Nach der Genehmigung können Sie das Modell herunterladen, indem Sie zu dem Verzeichnis zurückkehren, in das Sie die Text Generation Web UI heruntergeladen haben, und dort

den folgenden Befehl ausführen:

1 python download-model.py meta-llama/Llama-2-7b-chat-hf7. Ausführen der Text Generation Web UI

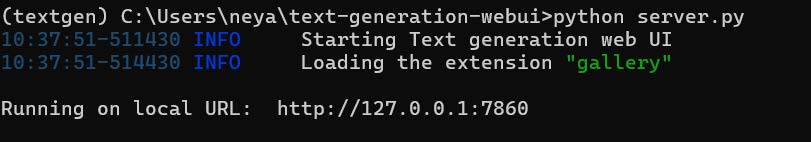

Führen Sie den folgenden Befehl aus, um die Text Generation Web UI zu starten. Sobald der Server läuft, ist die Benutzeroberfläche über einen Webbrowser zugänglich:

1 python server.py

Wenn alles ohne Fehler läuft, zeigt die Konsole URLs an, auf die Sie über Ihren Webbrowser zugreifen können, um die Benutzeroberfläche zu sehen.

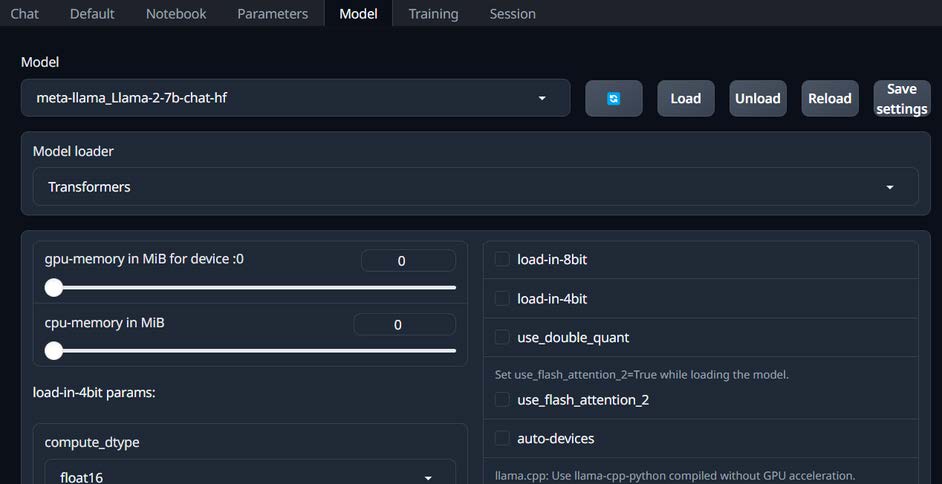

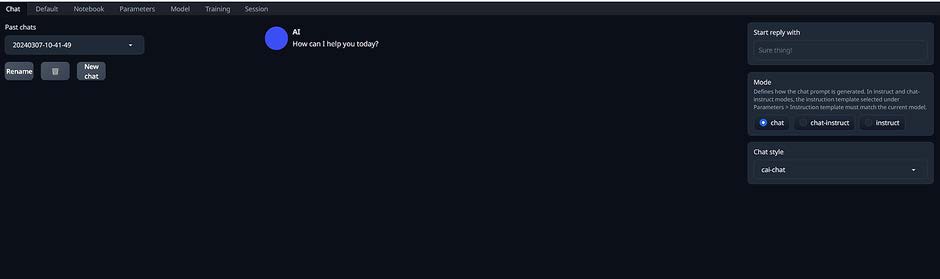

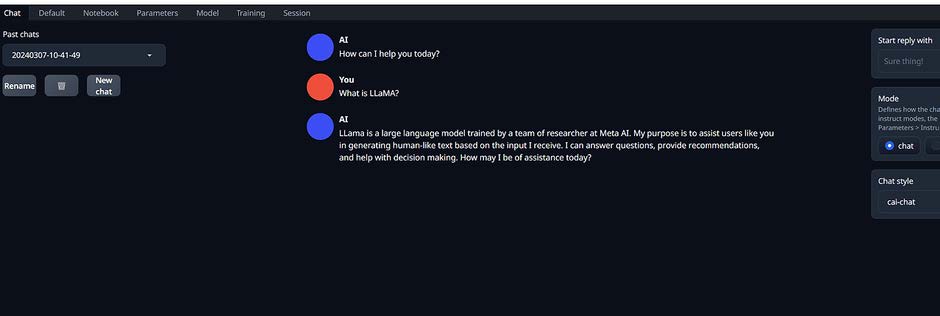

8. Laden des Modells

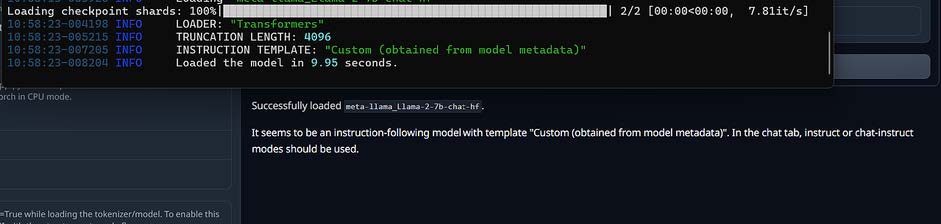

Jetzt müssen Sie das heruntergeladene Modell über die Benutzeroberfläche laden. Gehen Sie in der Benutzeroberfläche auf die Registerkarte „Model“, wo Sie das heruntergeladene Modell sehen und zur Verwendung laden können.

Sobald das Modell erfolgreich geladen ist, sind alle Vorbereitungen abgeschlossen. Wenn Sie zum Menü Chat in der Benutzeroberfläche zurückkehren, können Sie den Chat starten.

Zusammenfassend haben wir uns angesehen, wie Sie Ihre eigene KI-Chat-App ohne Vorkenntnisse der KI betreiben können. Die öffentlich freigegebene LLaMA hat zwar noch Einschränkungen, aber sie ist Open-Source und es wird erwartet, dass viele Entwickler diese Herausforderungen schnell überwinden werden. In der Tat werden derzeit viele fein abgestimmte Modelle auf der Grundlage von LLaMA entwickelt. Wir können uns in Zukunft auf eine verbesserte Leistung in verschiedenen Sprachen und Bereichen freuen.